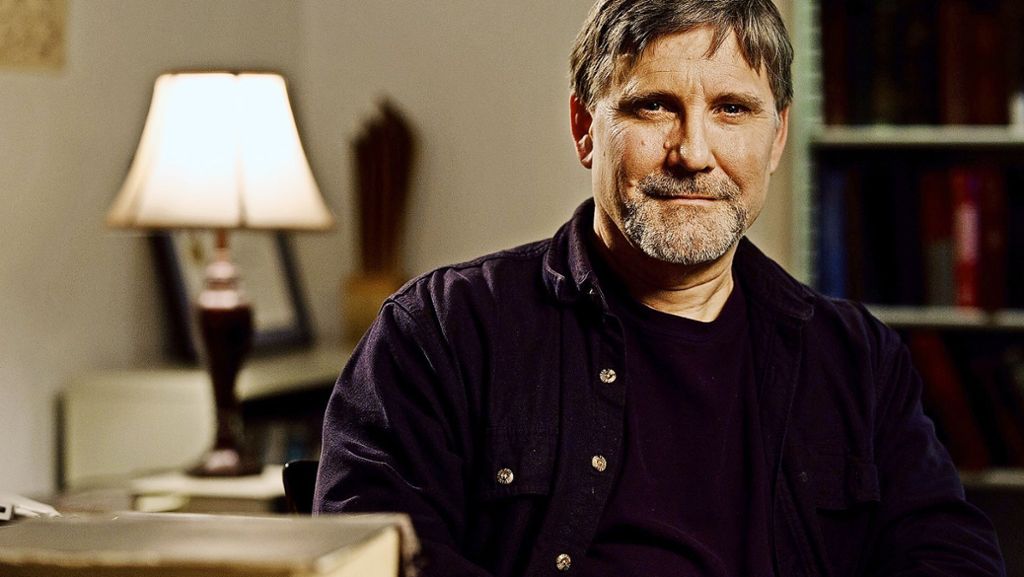

Der Sprachforscher und Informatiker Gregory Crane will die geisteswissenschafte Forschung um Methoden zur Verarbeitung großer Datenmengen erweitern.

08.11.2016 - 06:00 Uhr

Stuttgart - Der Altphilologe und Informatiker Gregory Crane spricht am Mittwoch auf der Falling Walls Konferenz in Berlin. Der Humboldt-Professor für Digital Humanities an der Uni Leipzig erklärt im Interview, wie er eine Ideengeschichte von der Antike bis heute erstellen will, wie solche Methoden sein Fach verändern werden und wieso Philologen lernen müssen zu programmieren.

Herr Crane, Sie wollen Altgriechisch, Latein, klassisches Persisch, Althochdeutsch und andere Sprachen mittels Computerhilfe analysieren. „Digital Humanities“ – ist das eine Art Google Translate für ausgestorbene Sprachen?

Nein, uns geht es um viel mehr. Wir wollen Zusammenhänge in großen Mengen an Text neu entdecken, die der Mensch ohne maschinelle Hilfe nicht finden kann.

Was suchen Sie in diesen großen Mengen an Text und wie gehen Sie vor?

Wir suchen Gemeinsamkeiten: Der Computer findet ähnliche Ideen in Texten. Maschinen sind gut darin, Muster zu erkennen. Die Maschinen bringen uns so auf eine Spur, die wir ob der schieren Massen an Texten auf analoge Art und Weise nie gefunden hätten. Kein Mensch kann diese Masse an Texten lesen, geschweige denn den Überblick behalten und Muster darin finden.

Welche Muster finden Ihre Algorithmen beispielsweise?

Wir wollen zum Beispiel eine riesige Sammlung an Büchern über die Geschichte des christlichen Denkens durchforsten. Wir haben bereits 35 Millionen Wörter in Altgriechisch analysiert und können jetzt sehen, was die großen Tendenzen darin sind. Wir bauen ein neues Verständnis für die Entwicklung christlichen Denkens auf. Ohne statistische Methoden wäre das nicht möglich.

Werden Statistik und Geisteswissenschaft neue Freunde?

Das sollten sie zumindest. Wir haben oftmals in den Geisteswissenschaften noch keine Ahnung von Statistik. Wir haben manchmal eine Allergie gegen mathematische Analysen.

Sie wollen alte Texte mit Big-Data-Methoden analysieren. Bei Ihnen geht es nicht mehr nur um Statistik, sondern um moderne Künstliche-Intelligenz-Algorithmen. Können Geisteswissenschaftler solche Methoden je selbst anwenden?

Aus meiner Sicht müssen wir das. Wenn wir die beste Forschung betreiben wollen – was immer unser Anspruch sein sollte –, dann brauchen wir die besten Algorithmen. Wir müssen sie selbst entwickeln, denn wir brauchen nicht nur alte Algorithmen, die bereits gemacht und für andere Anwendungen gedacht sind. Deshalb müssen wir programmieren lernen. Eine neue Form der Ausbildung für manche Geisteswissenschaftler ist notwendig.

Das hätte keine geringen Folgen. Haben Sie oder Ihre Kollegen denn Erfolge im Programmieren? Hat Ihre Idee den Praxistest schon bestanden?

Ich würde sagen, ich kann viele technischen Probleme lösen, wenn ich genug Zeit habe. Einer meiner ehemaligen Studenten arbeitet jetzt in den USA als Informatiker zusammen mit meinem akademischen Assistenten in Leipzig. Der Informatiker hat ein Modell für uns entwickelt, und mein Leipziger Mitarbeiter, ein Geisteswissenschaftler, meinte: ‚Ich hätte das, was der Informatiker an einem Tag gemacht hat, selbst machen können innerhalb von zwei Wochen.‘ Er hat alles verstanden, was der Informatiker gemacht hat!

Der springende Punkt ist aber, dass er dafür 14-mal so lang gebraucht hätte. Ist es da nicht effizienter und auch sicherer, sich Hilfe von Informatikern zu holen, von Spezialisten?

Die Methoden, die wir brauchen, sind sehr teuer. In Deutschland ist es nicht möglich, mit unserem Budget einen privaten Entwickler zu bezahlen, das kostet schnell mal 100 000 Euro. Und die Mitarbeiter der Informatik an der Uni haben eigene Aufgaben, die müssen ihre Forschung machen – das sind ja keine Hilfsingenieure für uns. Deshalb ist es notwendig, dass wir die Sache selbst lernen.

Wollen Sie Ihre Plattformen auch interdisziplinär nutzen? Kann man verschiedene Sprachen zusammen in ein System werfen?

Ja, das ist unser nächstes Ziel. Wir wollen ein größeres Thema angehen: Ich will Ideen von Altgriechenland bis heute vergleichen. Dafür muss man große Mengen von Text in verschiedenen Sprachen analysieren, unter anderem Griechisch, Latein, Armenisch und Arabisch. Das können wir, wenn wir die richtige Infrastruktur haben.

Automatische Übersetzungen sind fehlerbehaftet. Besteht nicht die Gefahr, dass die Maschinen etwas falsch verstehen?

Maschinelle Übersetzung ist noch nicht perfekt, aber sie wird sich auch dank syntaktischer und grammatikalischer Analysen immer mehr verbessern. Zudem leistet der Computer ja vor allem die Vorarbeit: Am Ende schauen wieder Menschen darauf, interpretieren und forschen.

Ich könnte mir vorstellen, dass nicht alle Geisteswissenschaftler begeistert sind von Ihren Big-Data-Methoden. Erfahren Sie Widerstand in Ihrem Fach?

Natürlich sind viele skeptisch. Und andere sagen: Ich bin offen für digitale Methoden, wenn ich selbst nichts Neues lernen muss. Aber ich sage: Wenn wir jetzt nichts Neues lernen und anwenden, werden wir auch keine neuen Erkenntnisse hervorbringen. Wir haben in diesem alten Fach Altgriechisch und Altlatein jahrtausendelang studiert. Aber jetzt stehen wir wieder am Anfang. Wir sollten uns auf diese neue Chance einlassen. Wir müssen alle unsere Ideen von Sprache überdenken.

Das erfordert Mut von Ihren Kollegen. Was versprechen Sie Ihnen für die Zukunft?

Wenn wir Texte und Bücher auf diese Weise analysieren, haben wir so etwas wie ein Hubble-Teleskop für unsere Kultur. Wir können zum ersten Mal Geschichte ganz neu betrachten. Wer hat wen zitiert? Wir können Ketten von Einfluss automatisch finden und nachweisen, Netzwerke von Ideen und wie sie durch die Welt ziehen.