Linguisten der Universität Stuttgart arbeiten daran, automatische Übersetzungen durch Computer zu verbessern. Sie setzen dabei nicht allein auf schiere Rechenpower wie etwa Google, sondern wollen auch grammatikalische Regeln in die Algorithmen integrieren.

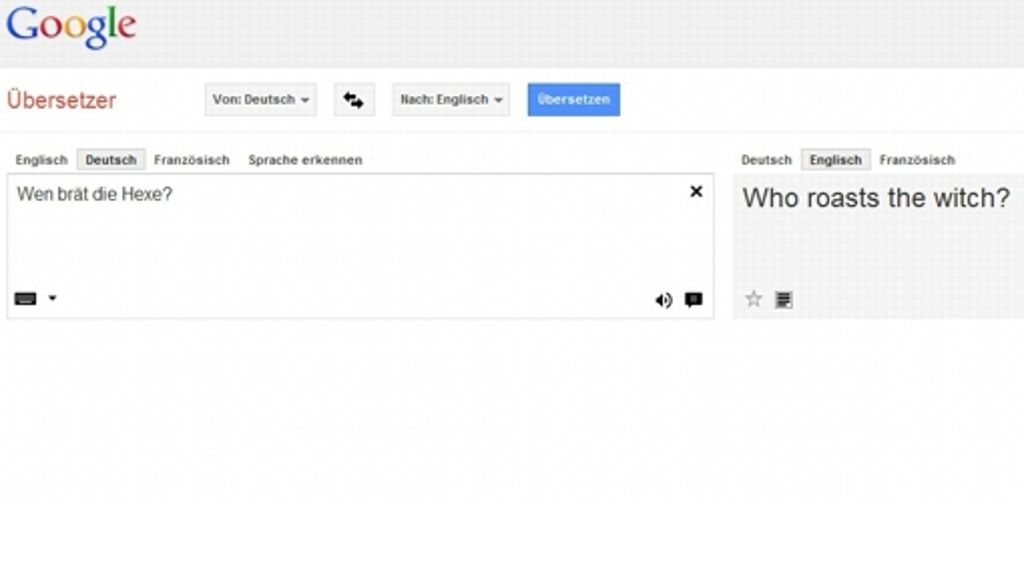

Stuttgart - Wer über Sprache und Computer redet, hat die Lacher schnell auf seiner Seite. „Wen brät die Hexe?“, fragt Jonas Kuhn das Google-Übersetzungsprogramm. „Who roasts the witch?“ spuckt das Programm auf, also: „Wer brät die Hexe?“ Da hat die Software Subjekt und Objekt verwechselt. Die Software hat keine Ahnung von Märchen, denn sie fragt nach: „Oder meinten Sie: ‚Wen berät die Hexe?’“

Solche Fehler gibt es zuhauf. Sie sind der Komplexität der Sprachen geschuldet. Doch eigentlich ist es an dem Computerlinguisten Kuhn, daran zu arbeiten. Und er ist mit den Ergebnissen seiner Fachkollegen zufrieden: „Die Übersetzungsprogramme funktionieren inzwischen sehr, sehr gut.“ Das gelte für Übersetzungen von Google, Microsoft und anderen gleichermaßen.

In den vergangenen Jahren hat die Computerlinguistik enorme Fortschritte gemacht. Die Sprachausgabe von Texten über Computer und Lautsprecher funktioniert tadellos, Sprachkommandos ans Navi oder zum Diktieren ebenfalls. Die Computerlinguistik habe sich zu einem fruchtbaren Forschungsfeld gemausert, sagt Kuhn.

Jede Übersetzung steht schon irgendwo im Internet

Der 41-jährige Wissenschaftler hat in den 90er Jahren in Stuttgart Computerlinguistik studiert. Nach Stationen im Ausland ist er im Jahr 2010 auf einen Lehrstuhl für Maschinelle Sprachverarbeitung an die Universität Stuttgart zurückgekehrt. Auf der Veranstaltung „Fragen an die Wissenschaft“ – einer Aktion von VHS, StZ und drei Stuttgarter Hochschulen – erläuterte Kuhn, dass sein Forschungsfeld vor allem davon profitiere, dass sich zwei wissenschaftliche Lager endlich näherkommen. Die eine Seite könnte man die Google-Fraktion nennen, die das Übersetzungsproblem mit schierer Rechenpower zu lösen versucht. Deren Credo könnte lauten: Jeder Satz steht schon irgendwo im Internet in der gewünschten Übersetzung – man muss ihn nur finden. Dafür reicht es aus, eine gigantische Datenmenge mit statistischen Methoden zu durchforsten.

Und wenn die Software den Satz „Wen brät die Hexe?“ falsch übersetzt, liegt das bloß an der geringen Textmenge an Märchen im Web. Ein Sprachverständnis setzt dieser Ansatz nicht voraus, und kommt trotzdem zu verblüffenden Erfolgen, etwa bei Mehrdeutigkeiten. So kann der Übersetzungsdienst von Google in vielen Fällen durchaus unterscheiden, ob mit „Anhänger“ ein beladbarer Wagen oder der Anhänger einer politischen Partei gemeint ist.

Im anderen wissenschaftlichen Lager sitzen die klassischen Linguisten, die Sprache als regelbasiertes System beschreiben. Hauptaktivist ist der Amerikaner Noam Chomsky, der Generationen von Linguisten geprägt hat. Sie suchen nach den verborgenen Strukturen der Sprache, die womöglich schon von Geburt an im Gehirn verankert sind. Die jüngere Forschergeneration, zu der Kuhn zählt, sieht aber die Zeit reif für eine Kombination beider Ansätze. „Unter Forschern kursiert die Frage, ob eine große Datenmenge und brachiale Rechenkraft ausreichen, oder ob man auch die Sprache verstehen muss“, sagt Kuhn. Seine Antwort: „Linguistisches Wissen hilft.“

Kuhns Arbeitsgruppe ergänzt beispielsweise die statistische Textsammelmethode um einfache grammatikalische Regeln, etwa Satzstellung von Subjekt und Objekt und Kasus. „Die Satzanalyse läuft dann in der Maschine mit Hunderttausenden Sätzen ab“, erklärt der Forscher. In der Sprachverarbeitung bringt das zwar nur eine wenige Prozentpunkte höhere Trefferquote. „Das erscheint wenig, ist aber ein großer Schritt“, sagt Kuhn.