Die Miniaturisierung der Schaltkreise ist bald ausgereizt. Neue Konzepte wie Quantencomputer und neuromorphe Computer sollen die Rechenleistung weiter steigern. Doch von der praktischen Anwendung sind sie noch ein gutes Stück entfernt.

Stuttgart - Auf das Moore’sche Gesetz war jahrzehntelang Verlass: Bereits 1965 sagte der amerikanische Ingenieur und spätere Gründer des Chipherstellers Intel, Gordon Moore, voraus, dass sich die Zahl der Recheneinheiten auf einem Computerchip alle ein, zwei Jahre verdoppeln werde. Mit Recheneinheiten sind die Transistoren gemeint – winzige elektronische Schalter, die den Stromfluss in einem Computerchip steuern. Mehr Transistoren bedeuten mehr Leistung. Die Computer wurden von Jahr zu Jahr immer besser, schneller und dabei sogar noch billiger. Auch das sagte Gordon Moore voraus.

Allerdings kann das aus prinzipiellen Gründen nicht ewig gut gehen. Mathematisch entspricht das Moore’sche Gesetz einer Exponentialfunktion. Ein schöner Vergleich ist die Schachlegende, derzufolge der Erfinder des Spiels einen vermeintlich bescheidenen Lohn vom König verlangte. Er wünschte sich Reiskörner. Auf das erste Schachfeld eines. Auf das zweite die doppelte Menge, also zwei. Auf das dritte dann zwei mal zwei mal zwei, also acht. Und mit jedem weiteren Feld erneut das Doppelte. Mit dem 64. Feld überstieg die nötige Reismenge längst die Weltjahresproduktion.

Die technischen Hürden werden größer

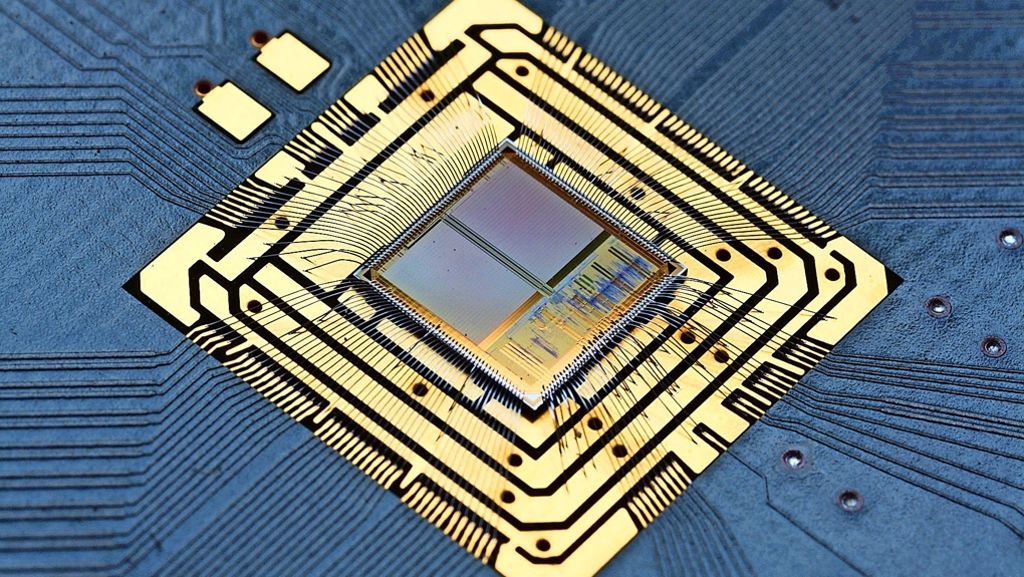

Beim Computer ist die limitierende Größe nicht die Anzahl der Transistoren auf dem Chip, sondern die Breite des einzelnen Transistors. Lagen die Abmessungen vor zehn Jahren noch bei 65 Nanometern (Millionstel Millimeter), liegt die Strukturbreite heute bei 14 Nanometern. Den nächsten Schritt will Intel im nächsten Jahr mit zehn Nanometern gehen. Die technischen Hürden der Miniaturisierung werden aber immer größer, da im Nanometerbereich die Strukturen nur noch wenige Dutzend Atome groß sind.

Neben der Transistorgröße drehen die Ingenieure aber noch an anderen Schrauben, um die Leistung zu erhöhen. Sie variieren die Taktfrequenz, packen auf einen Chip mehrere Prozessorkerne und lassen in diesen Kernen die Programme in optimierten Aufgabenpäckchen laufen. Das macht Prozessoren und Software aber immer komplexer, so dass weitere Leistungssteigerungen eine Herausforderung seien, sagt Intel-Entwickler Joshua Fryman.

Prozessoren werden zu komplex

Computerexperten diskutieren schon lange, was nach dem Moore’schen Gesetz kommt. „Das derzeitige Limit dürfte bei Strukturbreiten von zehn bis zwölf Nanometern liegen“, sagt John Shalf vom Lawrence Berkeley National Laboratory in Kalifornien. „Wir haben da nichts mehr in petto.“ Dem will Fryman nur in Teilen zustimmen. Zwar stoße die Miniaturisierung an ihre atomare Grenze, zum klassischen Transistor sei aber keine Alternative in Sicht. Vielmehr gelte es, die Möglichkeiten weiter auszuschöpfen – etwa die Taktfrequenz weiter zu erhöhen und das Powermanagement zu verbessern. Fryman jedenfalls ist optimistisch, die Leitung der Chips weiter verbessern zu können – auch wenn man nicht wie bisher einfach mehr Transistoren auf eine Fläche packen kann.

Zwei Technologien könnten dem klassischen Rechner Konkurrenz machen: der Quantencomputer und sogenannte neuromorphe Computer. Beide Technologien stecken bestenfalls noch in den Kinderschuhen. Doch Fachleute knüpfen große Hoffnungen daran.

Hoffnungsträger Quantencomputer

Beim Quantencomputer werden quantenphysikalische Prinzipien genutzt, um Berechnungen hochparallel und dadurch äußerst schnell auszuführen. Die Basiseinheit sind die Quantenbits (Qubits), die Forscher in rund einem halben Dutzend verschiedenen Techniken realisieren. Dazu zählen etwa Atome in einer Atomfalle, supraleitende Schaltkreise, Unregelmäßigkeiten in Diamantgittern oder ganz exotische physikalische Phänomene, berichtet Damian Steiger von der Eidgenössisch Technischen Hochschule (ETH) in Zürich. Die Techniken sind nur schwer zu beherrschen, bislang sind Quantencomputer bis maximal 10 bis 20 Qubits realisiert. Für einen leistungsfähigen Quantencomputer bräuchte man ungefähr 1000 Qubits. Ob das zu schaffen ist, darüber gehen die Meinungen auseinander.

Quantencomputer werden auch als Killer der aktuellen Verschlüsselungstechnik gesehen, was manchen Sorge bereitet, aber das Interesse der Geheimdienste geweckt hat. Dauert das Knacken einer Botschaft, die mit dem gängigen RSA-Verfahren verschlüsselt ist, mit einem klassischen Computer rund eine Million Rechenstunden (über 100 Jahre), so würde ein Quantencomputer dafür nur zehn Stunden brauchen, rechnet Steiger vor.

Der Computerexperte schränkt aber ein: Quantencomputer können nur da ihre ex-treme Rechenleistung ausspielen, wo es passende Algorithmen, also Rechenvorschriften, gibt. Davon existieren aber nur eine Handvoll. Das Brechen von Verschlüsselungen, das Sortieren und Durchsuchen großer Datensätze gehören beispielsweise dazu. „Existiert kein Algorithmus, so ist der Quantencomputer auch nicht schneller als ein klassischer Computer“, sagt Steiger. In der Hoffnung, dass es irgendwann einmal einen voll funktionsfähigen Quantencomputer gibt, arbeiten daher viele schon an Algorithmen und Software dafür.

Mustererkennung wie beim menschlichen Gehirn

Während klassische Computer mit höherer Leistung immer mehr Strom verbrauchen, ist eine altbewährte Recheneinheit besonders energieeffizient: unser Gehirn. „Unser Gehirn verbraucht im Schnitt nur 20 Watt. Eine Banane am Tag reicht“, sagt Karlheinz Meier von der Universität Heidelberg. Der Physiker entwickelt sogenannte neuromorphe Computer. „Wir wollen Aspekte der Struktur und Funktion des Gehirns für elektronische Schaltkreise nutzen“, sagt der Forscher. Im Fokus stehen dabei die Neuronen und deren Verbindungen, die Synapsen. Das menschliche Gehirn verfügt über hundert Milliarden Neuronen und noch mehr Synapsen.

Durch deren Verschaltung und Funktionsweise erreicht das Gehirn eine Leistungsfähigkeit, an die kein Computer herankommt. Zwar ist der Rechner in Sachen Arithmetik schneller, in der Bild- oder Mustererkennung schneidet das Gehirn aber mühelos besser ab. Das einzelne Neuron rechnet nicht digital, sondern sammelt die elektrischen Signale verbundener Neuronen, bis eine Schwelle überschritten ist. Erst dann „feuert“ das Neuron selbst. Auf Basis kleiner Schaltkreise, die je ein Neuron simulieren, hat das Team um Meier einen neuronalen Chip mit 200 000 Neuronen und 50 Millionen Synapsen entwickelt.

Innerhalb eines öffentlich geförderten Projekts können Wissenschaftler darauf zugreifen und damit experimentieren. Ein Forschungsbereich beschäftigt sich etwa damit, wie man lernfähige Systeme aufbaut, die zur Mustererkennung eingesetzt werden können. Meier glaubt aber nicht, dass neuromorphe Computer die heutigen Rechner ersetzen werden. Eher sei es denkbar, dass in Zukunft in Computern oder Smartphones neben einem klassischen Chip auch ein neuromorpher Chip zum Einsatz kommt und das Anwendungsspek-trum erweitert.

Quantencomputer

Bits In einem Computer werden Daten im sogenannten Binärsystem gespeichert. Das heißt, es gibt an einer bestimmten Stelle des Speichers nur zwei Zustände: Null oder Eins. Diese kleinste Informationseinheit ist ein Bit.

Qubits Das quantenmechanische Pendant zu den Bits sind Qubits. Ein Qubit kann sich im Gegensatz zu einem Bit für eine bestimmte Zeitspanne auch in einem Zwischenzustand aus Null und Eins befinden. Dieser Zustand wird auch Superposition genannt.

Fallen

Im Labor lassen sich Qubits zum Beispiel mit Ionen oder supraleitenden Schleifen darstellen – sogenannten Squids. Bei der Ionen-Variante werden Atome, denen ein Elektron fehlt, durch elektrische Felder in sogenannten Paul-Fallen gefangen. Ein nicht angeregtes Ion entspricht dabei dem Zustand Null, ein angeregtes dem Zustand Eins. Ein angeregtes Ion ist ein Ion, dem Energie zugeführt wurde, wodurch das äußere Elektron ein höheres Energieniveau aufweist.